AURORACAP让机器秒懂视频并生动描述

2025-02-02 14:24阅读:

人工智能咨询培训老师叶梓 转载标明出处

想要掌握如何将大模型的力量发挥到极致吗?叶老师带您深入了解 Llama Factory ——

一款革命性的大模型微调工具(限时免费)。

1小时实战课程,您将学习到如何轻松上手并有效利用 Llama Factory 来微调您的模型,以发挥其最大潜力。

CSDN教学平台录播地址:https://edu.csdn.net/course/detail/39987

随着人工智能技术的不断发展,计算机视觉和自然语言处理领域的交叉研究逐渐成为热点。视频详细描述生成(Video Detailed

Captioning)作为这一交叉领域的关键任务,旨在通过自然语言生成全面、连贯且详细的视频内容描述。这一任务不仅能够帮助人们更好地理解和生成视频内容,还在机器人、视频编辑、视频生成等多个领域具有重要的应用前景。然而,以往的研究中,视频描述数据的匮乏以及缺乏有效的评估指标,严重限制了这一领域的研究进展。

由华盛顿大学、Pika

Lab、斯坦福大学、哈佛大学和纽约大学的研究人员组成的研究团队提出了一种名为AURORACAP的视频描述生成模型,并构建了一个全新的视频详细描述基准测试VDC(Video

Detailed Captions),为视频详细描述生成任务带来了新的突破。

AURORACAP

基于大型多模态模型(大模型),采用简洁的架构设计,无需额外参数进行时间建模。为解决长视频序列带来的计算开销问题,研究者引入了

Token Merging 策略,通过逐步合并相似的视觉标记,显著减少了输入视觉标记的数量。具体来说,Token Merging 在

Transformer 层中交替划分标记,并基于注意力块中的 Key 特征计算标记之间的相似度,通

过二分图软匹配算法选择最相似的标记对进行合并。

实验结果表明,使用 Token Merging 策略后,AURORACAP 在多种基准测试中仅使用 10% 至 20%

的视觉标记,相比原始 ViT

生成的标记数量,性能几乎没有明显下降。这使得模型能够更高效地处理高分辨率和长视频序列的输入,同时保持优异的性能。

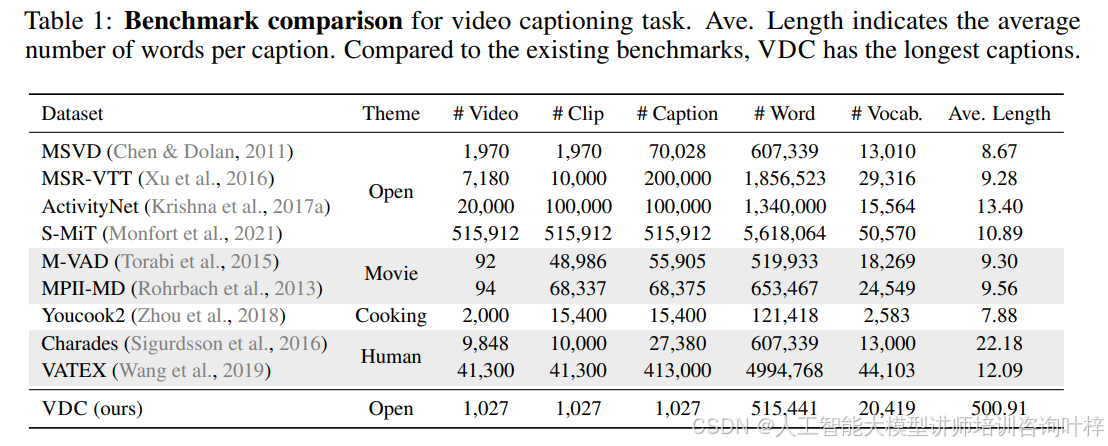

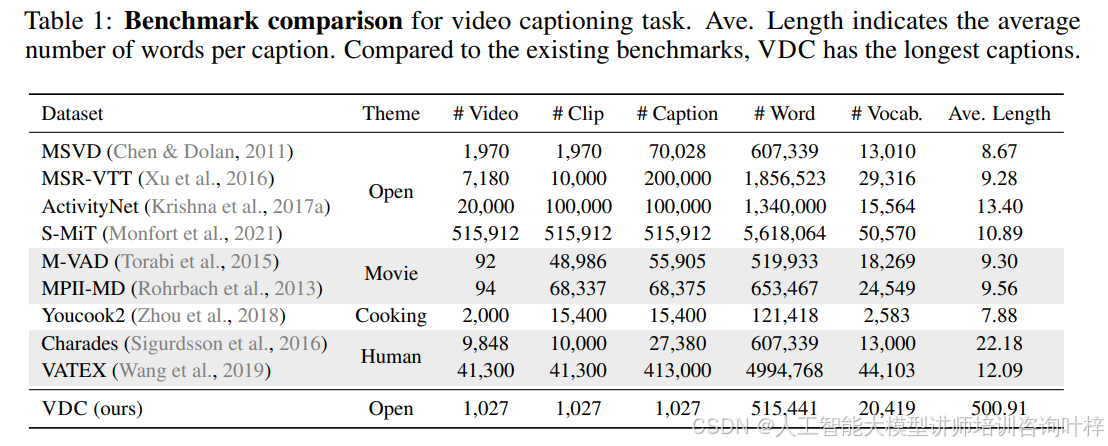

现有的视频描述基准测试大多只包含简单的描述,通常只有几十个单词,这限制了视频详细描述生成任务的研究。为了推动该领域的发展,研究者构建了

VDC 基准测试,包含超过 1000 个高质量的视频 -

文本对,覆盖广泛的主题类别。这些描述不仅包含丰富的世界知识、对象属性,还详细描述了相机运动和事件的时间动态。

![点击并拖拽以移动 AURORACAP让机器秒懂视频并生动描述]() 编辑

编辑

VDC 基准测试的一个显著特点是其描述的长度和细节程度。如 表 1 所示,VDC

的平均描述长度显著高于其他现有基准测试,详细描述的平均长度超过 500 个单词。这使得 VDC

成为第一个专注于详细视频描述的基准测试,为研究人员提供了一个更具挑战性和实用性的数据集。

为了更好地评估详细描述的质量,研究者提出了 VDCSCORE,这是一种基于大模型的新型评估指标。VDCSCORE

采用“分而治之”的策略,将长描述分解为多个简短的问答对,然后利用大模型对每个问答对的准确性进行评估。具体来说,首先使用大模型从详细描述中提取问答对,然后从预测描述中生成相应的答案,最后对每个问答对的答案进行匹配和评分。

VDCSCORE 的设计不仅能够更准确地评估详细描述的质量,还能够更好地反映人类对视频详细描述质量的判断。实验表明,VDCSCORE

与人类评估结果具有较高的相关性,优于传统的评估指标。

![点击并拖拽以移动 AURORACAP让机器秒懂视频并生动描述]() 编辑

编辑

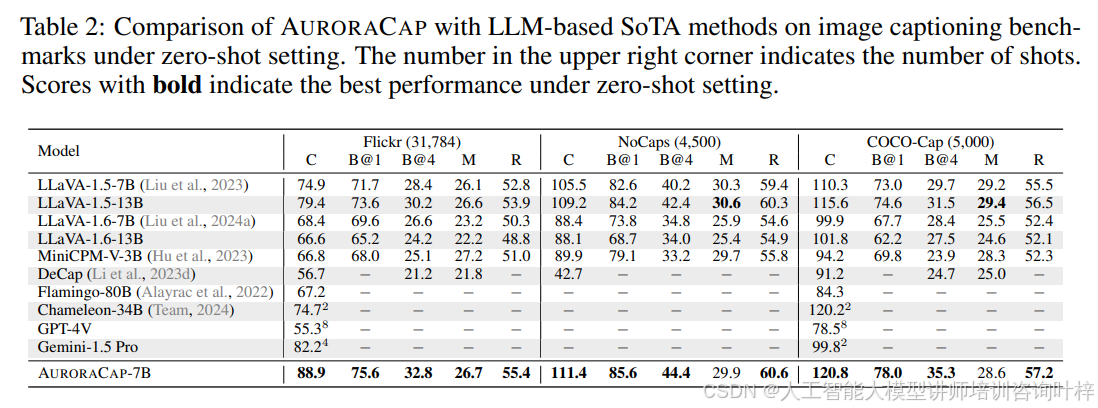

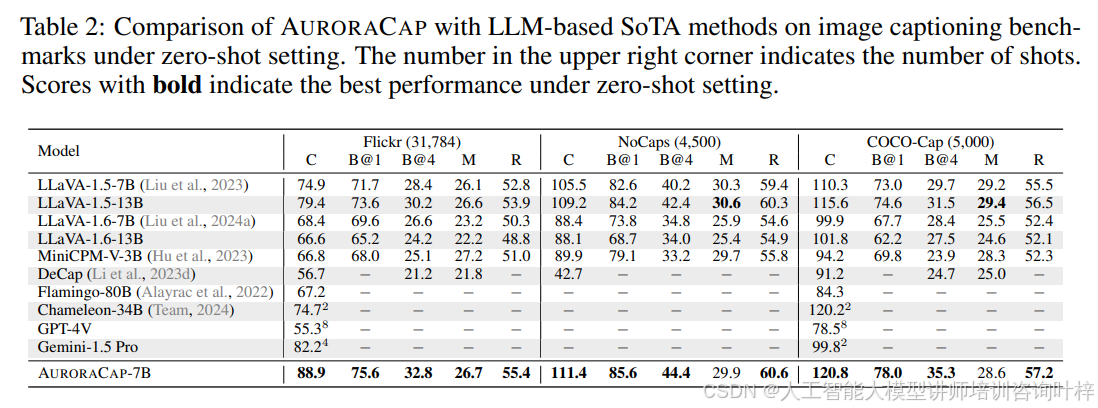

AURORACAP 在多个广泛使用的基准测试中表现出色。例如,在 表 2 中,AURORACAP 在 Flickr30k

数据集上取得了 88.9 的 CIDEr 分数,显著优于 GPT-4V(55.3)和 Gemini-1.5

Pro(82.2)。在视频描述任务中,AURORACAP 在 MSR-VTT 和 VATEX

数据集上也取得了优异的成绩。此外,在视频问答任务中,AURORACAP 在 ActivityNet-QA 和 iVQA

数据集上表现出色。

AURORACAP 和 VDC 基准测试的提出为视频详细描述生成任务带来了新的突破。AURORACAP 通过高效的 Token

Merging 策略,在减少计算开销的同时保持了优异的性能。VDC

基准测试为研究人员提供了一个全新的、更具挑战性的数据集,用于评估和改进视频详细描述生成模型。VDCSCORE

评估指标的引入,也为详细描述的评估提供了一种更精准的方法。

论文链接:

https://arxiv.org/pdf/2410.03051

项目链接:

https://github.com/InternLM/xtuner